Tin Tức

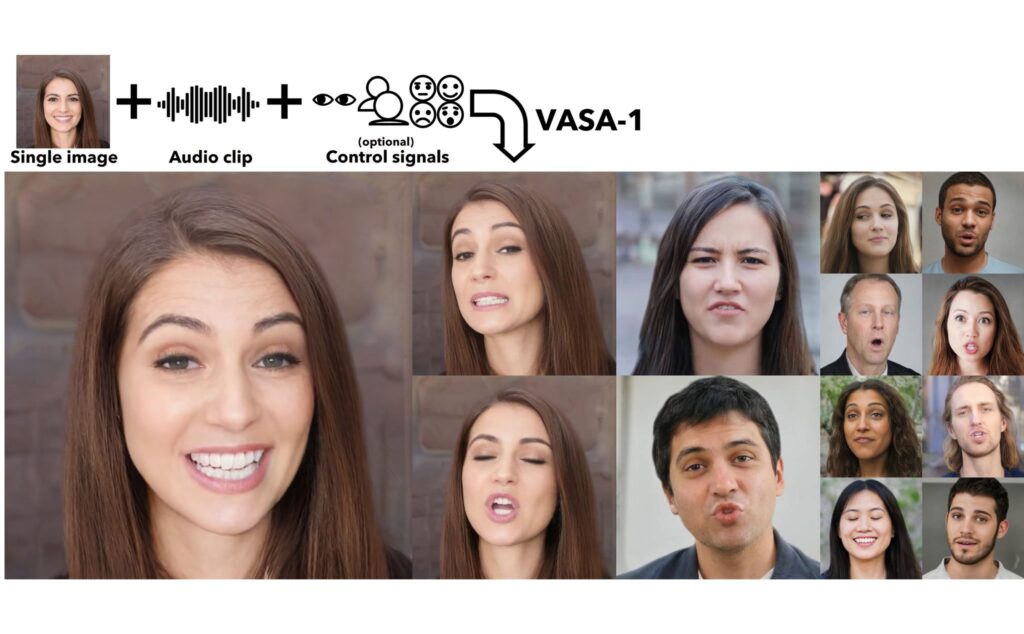

tạo video chân dung người nói chỉ bằng 1 hình tĩnh + voice

Theo nhóm nghiên cứu, VASA là một framework không chỉ có khả năng tạo ra chuyển động của môi, miệng một cách đồng bộ với âm thanh mà nó còn tạo ra nhiều biến đổi khác trên gương mặt để cố “giống thật” nhất. Họ cho biết gen model đã xử lý toàn bộ các biến đổi trên gương mặt và cả các góc mặt trong không gian latent để tạo ra kết quả cuối cùng là một video 512 x 512, 40 fps với độ trễ của tiếng và hình là không đáng kể.

Về hiệu quả, VASA có thể chạy với phần cứng desktop 1 con GPU 4090, đoạn video tạo ra ở chế độ phát trực tiếp chỉ có độ trễ 170ms khi play.

Hiện nhóm vẫn chưa có kế hoạch phát hành API hay sản phẩm cụ thể của VASA. Bên dưới đây là một số thí dụ, họ tạo ra những chân dung người bên dưới bằng StyleGAN2 hoặc DALL.E-3. Mời anh em xem qua.